어쩌다데싸

LLM(Large Language Model), 도대체 그게 뭔데? 본문

이제는 우리 일상에서 흔하게 접할 수 있는 ChatGPT, Claude 등과 같은 생성형 AI 서비스에는 LLM(Large Language Model)이 자리하고 있습니다. LLM은 단순한 기술을 넘어 다양한 산업과 분야에서 혁신적인 변화를 이끌고 있습니다. AI 챗봇, 번역기, 코딩 보조, 의료 및 법률 상담 등 LLM이 할 수 없는 것을 찾는 게 더 빠를 정도로 굉장히 많은 분야에서 LLM이 활용되고 있습니다.

그렇다면 LLM은 정확히 무엇이며, 왜 이렇게 주목받고 있을까요? 지금까지의 AI 모델과 어떤 차이점이 있는 걸까요?

단순히 많은 데이터를 학습했다고 해서 AI가 사람처럼 자연스러운 문장을 생성할 수 있는 것은 아닙니다. 우리가 LLM을 이해하려면, 이 모델이 어떤 방식으로 언어를 학습하고, 문맥을 이해하며, 적절한 응답을 생성하는지를 알아볼 필요가 있습니다.

이 글에서는 LLM이란 무엇인지, 어떻게 작동하는지, 그리고 어떻게 활용할 수 있는지를 알기 쉽게 정리해보려고 합니다.

LM (Language Model)

LLM을 이해하기 전에, 먼저 LM(Language Model)의 개념을 살펴보겠습니다. 언어 모델을 의미하는 LM은 주어진 문맥에서 가장 적절한 단어나 문장을 예측하는 모델입니다. 기계가 언어를 학습하는 방식 중 하나로, 텍스트에서 단어 또는 문장 시퀀스의 확률을 계산하여 자연스러운 문장을 생성하는 데 활용됩니다.

언어 모델에는 대표적으로 다음과 같은 방식이 있습니다.

- 순방향 예측 모델 : 이전 단어들을 기반으로 다음 단어의 확률을 예측하는 방식 (ex. GPT 시리즈)

- 양방향 예측 모델 : 문장의 앞뒤 정보를 모두 활용하여 특정 단어를 예측하는 방식 (ex. BERT)

LM의 연구는 지속적으로 발전해왔으며, 주요 발전 단계는 다음과 같습니다.

📍언어 모델의 발전 과정

1️⃣ 통계적 언어 모델(SLM, Statistical Language Model)

- 주어진 문장에서 단어가 등장할 확률을 계산하는 방식으로, n-gram 모델 등이 포함됩니다.

- 비교적 짧은 문맥(window)만 고려하며, 확률적으로 가장 가능성이 높은 단어를 예측합니다.

- 실행 속도가 빠르고 가벼운 장점이 있지만, 긴 문맥을 반영하지 못하는 한계가 있습니다.

2️⃣ 신경 언어 모델(NLM, Neural Language Model)

- 순환 신경망(RNN)과 같은 신경망 구조를 활용하여, 단어 시퀀스를 학습하고 확률을 계산하는 방식입니다.

- SLM보다 더 넓은 문맥을 반영할 수 있으며, 기계 번역, 문장 완성, 감정 분석 등 다양한 NLP 작업에 활용됩니다.

3️⃣ 사전 학습된 언어 모델(PLM, Pre-trained Language Model)

- 대규모 데이터셋을 사전에 학습한 모델로, 전이학습(Transfer Learning)을 통해 다양한 NLP 과제에 적용됩니다.

- 감정 분석, 질의응답, 문서 요약 등 특정 작업에 맞게 추가 학습(Fine-tuning)을 진행하여 성능을 높일 수 있습니다.

- 대표적인 모델로는 BERT와 GPT가 있으며, 이들은 사전 학습 후 미세 조정을 통해 다양한 언어 작업을 수행합니다.

4️⃣ 대형 언어 모델(LLM, Large Language Model)

- PLM을 확장한 형태로, 매우 큰 데이터셋과 거대한 파라미터(수십억~수천억 개)를 활용하여 학습된 모델입니다.

- 기존 PLM보다 훨씬 복잡한 작업을 처리할 수 있으며, 대화형 AI, 코드 생성, 창작 활동 등 폭넓은 분야에서 활용됩니다.

- 대표적인 예시로 GPT-4, Claude, LLaMA, Gemini 등이 있습니다.

- 현재 NLP 연구에서 가장 발전된 형태의 언어 모델로, 지속적으로 연구가 진행 중입니다.

연구자들은 PLM을 확장하면서 다운스트림 작업(사전훈련된 모델을 사용해서 풀어야 할 구체적인 과제)에서 모델 용량이 향상될 수 있다는 사실과, 소규모의 PLM과 다르게 대형 PLM이 일련의 복잡한 작업을 해결할 때 훨씬 좋은 성능을 보인다는 점을 발견했습니다. 이러한 대형 PLM을 두고 '대규모 언어 모델(LLM)'이라는 용어를 사용하기 시작했고, 현재의 LLM은 언어 모델의 가장 발전된 형태로 볼 수 있습니다.

2. LLM (Large Language Model)

LLM(Large Language Model)은 트랜스포머(Transformer) 모델을 기반으로 방대한 데이터를 학습한 대규모 자연어 처리 모델입니다. 방대한 데이터라고 하면 감이 잘 안 오겠지만, 기존의 언어 모델보다 훨씬 더 많은 데이터를 통해 수십억~수천억 개의 파라미터를 활용하여 학습되었습니다. 이렇게 방대한 양의 데이터를 학습했을 때, 다양한 자연어 처리 Task들을 하나의 모델로 수행할 수 있다는 특징을 갖게 되었습니다.

기존 NLP 모델은 특정 Task에 맞게 훈련된 경우가 많았지만, LLM은 하나의 모델이 다양한 작업을 수행할 수 있도록 설계된 것입니다. 그러나 LLM을 학습하는 과정은 매우 높은 연산 비용을 요구합니다. LLM은 수십억~수천억 개의 파라미터를 가지며, 모델을 훈련하는 데 고성능 GPU 및 대규모 분산 컴퓨팅 환경이 필수적입니다.

이러한 높은 진입장벽으로 인해, 최근에는 많은 기업이나 연구자들이 오픈소스 LLM 모델을 활용하여 Fine-Tuning 하거나, RAG를 통해 정확도를 올리거나, LoRA와 같은 경량화 기법을 적용해 특정 도메인에 맞게 최적화하는 방식이 활발하게 연구되고 있습니다.

(Fine-Tuning, RAG, LoRA 등은 LLM에서 자주 등장하는 관련 기법들입니다. 해당 내용은 뒤에서 더 자세히 설명하겠습니다.)

💡 NLP와 LLM의 관계

NLP는 인간의 언어를 이해하고 처리하는데 초점을 맞춘 인공지능 분야로, 문장 구문 분석, 텍스트 분류, 기계 번역, 질의응답, 감정 분석 등 다양한 텍스트 데이터에 관련한 Task들이 있습니다.

LM은 NLP의 Task들을 수행하는데 사용되는 대규모 자연어 데이터셋으로 사전에 훈련된 '대용량 언어 모델'로, LLM 덕분에 자연어 처리 기술 성능이 크게 발전했습니다.

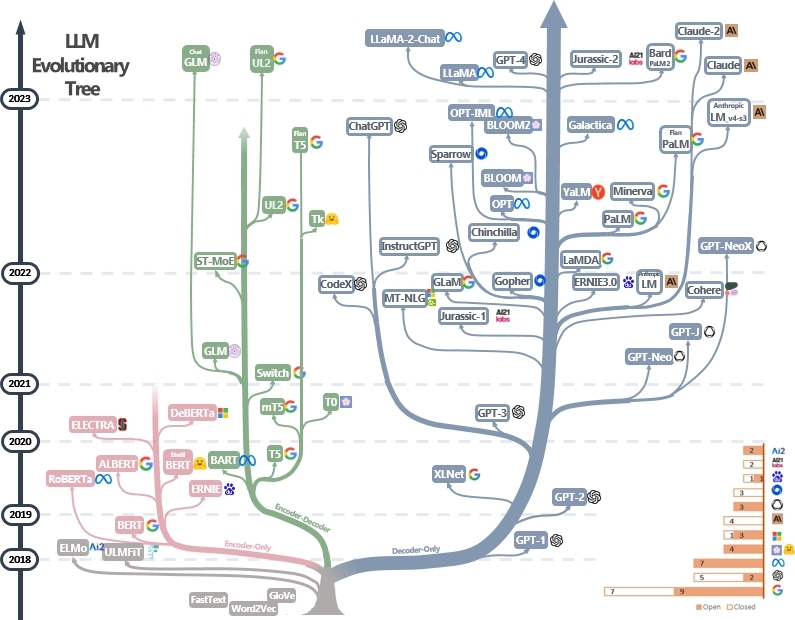

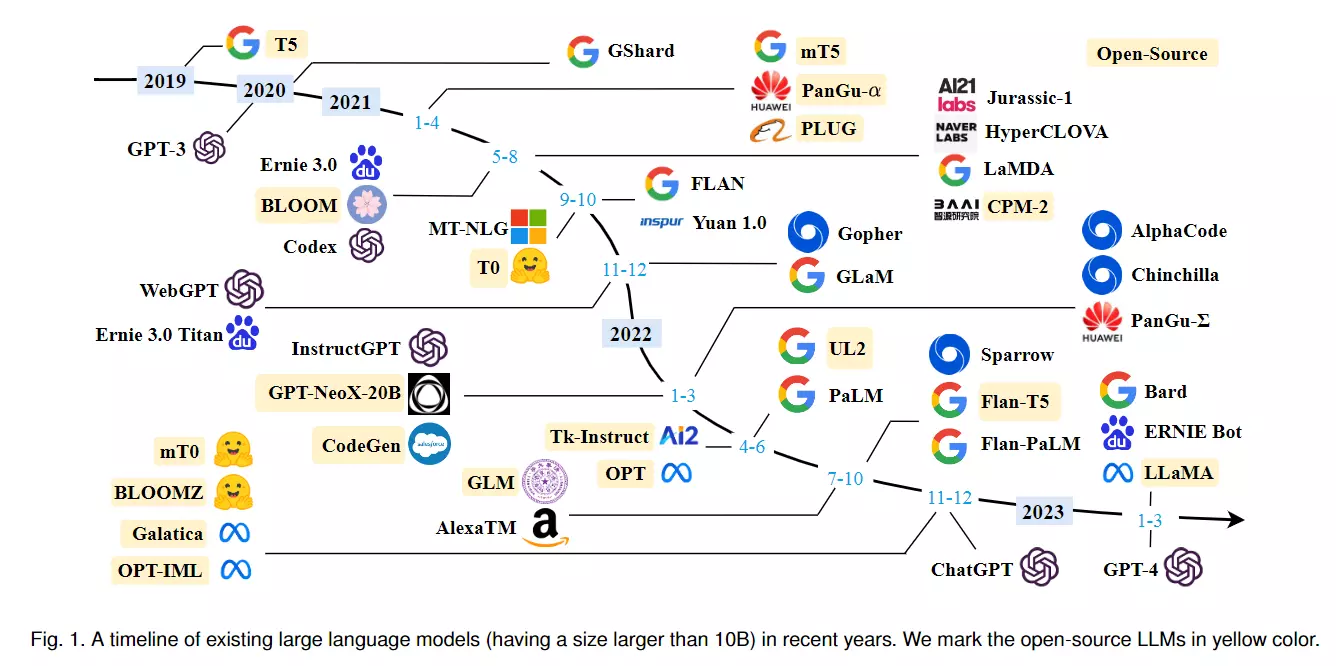

📍 LLM 모델 발전 과정

LLM은 지난 몇 년 동안 급격하게 발전하며 다양한 분야에서 활용되고 있습니다. 아래 이미지는 LLM 모델의 발전 계보를 보여주는 그래프로, 초기 언어 모델부터 최근의 LLM 모델까지의 흐름을 정리하고 있습니다.

그림에서 분홍색 가지는 Encoder 구조만 사용한 모델들이고, 초록색은 Encoder - Decoder 구조를, 파란색은 Decoder 구조만 사용한 모델들입니다. 3가지 유형의 모델들은 간략하게 알아 보겠습니다.

🔹 인코더-디코더 모델 (Encoder-Decoder, Seq2Seq)

- 주로 번역, 요약, 질의응답(Q&A) 등 자연어 변환(Transformation) 작업에 적합한 모델입니다.

- 문장의 전체적인 의미를 인코더가 압축하여 디코더가 생성하는 방식입니다.

- 대표 모델은 T5, BART, UL2, mT5 등이 있습니다.

- GPT 기반의 디코더 모델이 주목받으면서 상대적으로 관심이 줄어들었으나, 특정 NLP 작업에서는 여전히 강력한 성능을 보입니다.

🔹 인코더 전용 모델 (Encoder-Only)

- 주어진 문장의 의미를 깊이 이해하는 데 초점을 맞춥니다.

- 주로 문서 분류, 감성 분석, 개체명 인식(NER) 등의 NLP 작업에 사용됩니다.

- 대표 모델은 BERT, RoBERTa, ALBERT, ELECTRA 등이 있습니다.

- BERT 등장 이후 NLP 연구를 주도했지만, 생성형 AI 성장으로 상대적인 관심이 감소했습니다.

- 최근에는 GPT-4 등 디코더 모델이 주류를 이루면서 BERT 계열 모델의 연구는 점차 줄어드는 추세입니다.

🔹 디코더 전용 모델 (Decoder-Only, Autoregressive)

- 주어진 입력에 기반하여 다음 단어를 예측하는 방식으로 텍스트 생성에 최적화되어 있습니다.

- 주로 챗봇, 문서 생성, 코딩 지원 등 다양한 생성형 AI 작업에 활용됩니다.

- 대표 모델은 GPT 계열, LaMDA, PaLM, LLaMA, Claude 등이 있습니다.

- 2020년대 이후 가장 주목받고 있는 구조로, GPT-3의 등장(2020) 이후 디코더 전용 모델이 NLP 연구의 중심이 되었습니다.

📍 구조별 LLM 모델 특징

다음으로는, 각 유형별 모델의 특징과 대표적인 LLM 모델을 간략하게 정리한 표를 살펴 보겠습니다.

| Characteristic | Models | |

| Encoder-Decoder or Encoder-only (BERT-style) |

- Training : Masked Language Models - Model Type : Discriminative - Pre-training Task : Predict masked tokens |

BERT, RoBERTa, ALBERT, T5, GLM ... |

| Decoder-only (GPT-Style) |

- Training : Autoregressive Language Models - Model Type : Generative - Pre-training Task : Predict next word |

GPT-3, OPT, PaLM ,BLOOM, LLaMA... |

1) BERT 스타일 언어 모델 : 인코더-디코더 또는 인코더 전용

BERT 스타일의 언어 모델은 마스크드 언어 모델(Masked Language Model, MLM) 방식으로 학습됩니다.

즉, 문장에서 일부 단어를 마스킹(masking)한 후, 주변 문맥을 기반으로 이를 예측하도록 훈련됩니다.

이러한 훈련 방식 덕분에 모델은 문장의 양방향 문맥을 고려하여 학습할 수 있으며, 문맥 내 단어 간의 관계를 깊이 이해할 수 있습니다.

이러한 특징으로 인해 BERT 계열 모델은 감정 분석, 개체명 인식(NER), 문서 분류 등 다양한 NLP 작업에서 높은 성능을 보입니다.

✅ 대표적인 모델:

- BERT: Google이 개발한 최초의 마스크드 언어 모델

- RoBERTa: BERT의 변형으로, 더 많은 데이터를 활용해 학습된 모델

- ALBERT: BERT의 파라미터를 줄여 효율성을 높인 모델

- T5: BERT와 달리 인코더-디코더 구조를 가진 모델로, 문장 변환 작업에 최적화됨

2) GPT 스타일 언어 모델 : 디코더 전용

GPT 모델은 트랜스포머의 디코더 부분만을 활용하여, 앞의 단어들을 기반으로 다음 단어를 예측하는 방식(Autoregressive Language Model)으로 학습됩니다. 즉, 문장의 흐름을 따라가며 점진적으로 새로운 단어를 생성하는 것이 특징입니다.

GPT 연구자들은 다양한 작업(Task)에 추가적인 Fine-Tuning 없이도 모델을 활용할 수 있도록 연구를 진행했습니다. 이를 위해 방대한 데이터셋을 수집하고, 사람과 AI를 통해 품질을 검증하는 과정이 포함되었습니다. 이 과정에서 발견된 중요한 개념이 In-context Learning(문맥 학습)입니다.

GPT-3에서는 Few-shot Learning 기법이 도입되어, 모델이 질문과 몇 개의 예시만 보고도 적절한 답변을 생성할 수 있도록 학습되었습니다.

- Few-shot Learning: 모델이 몇 개의 예제를 참고하여 문맥을 이해하고 답변을 생성하는 방식.

- Zero-shot Learning: 예제 없이도 모델이 문제를 해결할 수 있는 방식.

이러한 발전 덕분에 ChatGPT와 같은 모델은 별도의 Fine-Tuning 없이도 다양한 질문에 대한 답변을 생성할 수 있으며, 문서 요약, 코드 생성, 창의적 글쓰기 등 다양한 다운스트림 작업에서 사용됩니다.

✅ 대표적인 모델:

- GPT-3: OpenAI가 개발한 175B 파라미터 모델

- GPT-4: 멀티모달 AI 기능이 추가된 최신 모델

- PaLM: Google의 초거대 언어 모델

- LLaMA: Meta가 개발한 오픈소스 LLM

최근 LLM 개발은 디코더 전용 모델(Decoder-only)이 주도하고 있으며, GPT-3 이후로도 디코더 중심의 연구가 지속되고 있습니다.

GPT-3는 GPT-2와 기본 구조(트랜스포머 아키텍처)가 거의 동일하며, Google의 PaLM이나 Meta의 LLaMA 또한 기본적인 트랜스포머 구조에서 큰 변화를 주지 않았다고 관련 논문에서 언급되었습니다. 그럼에도 불구하고 성능이 비약적으로 향상된 이유는 주로 모델의 규모(파라미터 수) 증가와 학습 데이터의 확장 때문입니다.

📌 LLM의 파라미터 수 변화

최초의 GPT 모델(GPT-1)은 1.17억 개(117M)의 파라미터를 가졌습니다. 이후 LLM이 발전하면서 파라미터 수는 급격히 증가했습니다.

✅ 대표적인 LLM 모델들의 파라미터 수 비교

- GPT-2: 15억 개 (1.5B)

- GPT-3: 1750억 개 (175B)

- GPT-4: (정확한 수치는 공개되지 않았으나, 1조 개 이상으로 추정됨)

- PaLM (Google): 5400억 개 (540B)

- LLaMA (Meta, 2023): 700억 개 (70B)

또한, LLM 모델의 이름에서 종종 "13B", "7B"와 같은 숫자를 볼 수 있는데, 이것은 해당 모델의 파라미터 수(10억 단위, B = Billion)를 의미합니다. 예를 들어, LLaMA-7B는 70억 개(7B)의 파라미터를 가지고, LLaMA-13B는 130억 개(13B)의 파라미터를 가집니다.

하지만 LLM의 성능 향상이 단순히 파라미터 수 증가 때문만은 아닙니다. 다음과 같은 요소들이 함께 영향을 미쳤습니다.

1️⃣ 더 많은 학습 데이터

- GPT-3 이후로 학습 데이터의 규모가 기하급수적으로 증가하며 모델이 다양한 문맥을 이해하는 능력이 향상되었습니다.

- 웹 문서뿐만 아니라, 코드, 학술 논문, 대화 데이터 등이 포함되었습니다.

2️⃣ 더 나은 훈련 기법

- Mixture of Experts (MoE): 여러 개의 소형 모델을 조합하여 특정 상황에서 필요한 부분만 활성화하는 방식으로 효율성을 높이는 기법.

- RLHF (Reinforcement Learning from Human Feedback): ChatGPT에 도입된 강화학습 기법으로, 사람이 모델의 출력을 평가하고 개선하도록 학습.

3️⃣ 더 나은 데이터 필터링 및 정제

- 단순한 웹 크롤링 데이터를 학습하는 것이 아니라 고품질 데이터를 선별하여 학습.

- 예를 들어 OpenAI는 WebText와 같은 정제된 데이터를 활용하여 성능을 향상시켰음.

4️⃣ 컴퓨팅 인프라의 발전

- 대형 LLM을 학습시키기 위해 NVIDIA A100, H100과 같은 최신 고성능 GPU 및 TPU 클러스터가 사용되며, 모델 훈련 속도와 최적화가 개선됨.

단순히 파라미터 수가 많다고 해서 성능이 무조건 향상되는 것은 아니며, 이처럼 데이터 품질, 학습 방법, 강화학습 기법 등이 중요한 역할을 합니다.

3. LLM 작동 방식

LLM(Large Language Model)은 딥러닝을 기반으로 방대한 양의 데이터를 사전 학습(Pre-training)한 전이학습(Transfer Learning) 모델입니다. 이 모델은 문장에서 가장 자연스러운 단어 시퀀스를 생성하기 위해, 단어 간의 관계와 문맥(Context)을 학습하여 의미를 파악합니다.

기존의 전통적인 언어 모델과 달리, LLM은 사전적 의미나 문법 규칙을 직접 인식하는 것이 아니라, 학습한 데이터 내에서 단어들의 패턴과 확률적 분포를 분석하여 문장을 생성합니다. 즉, 우리가 문장을 이해할 때 문법을 의식적으로 따지는 것이 아니라 경험적으로 익힌 패턴을 기반으로 언어를 사용하는 것과 유사합니다.

예를 들어, "오늘 날씨는 어때?" 라는 질문을 던졌을 때, 사람은 "맑음", "흐림" 같은 답변을 예상하지만, LLM은 이 문장이 질문이라는 것을 "학습된 패턴"을 기반으로 이해하며, 학습 데이터에 따라 "오늘 날씨가 궁금하구나" 같은 응답을 생성할 수도 있습니다.

중요한 점은, LLM은 원칙적으로 대화 시스템이 아니라 "주어진 문맥에서 확률적으로 가장 적합한 다음 단어를 예측하는 모델"이라는 점입니다. 즉, LLM은 의미를 논리적으로 이해한다기보다는, 방대한 데이터를 기반으로 단어와 문장 패턴을 학습하여 자연스럽게 응답을 생성하는 방식으로 작동합니다. 딥러닝 모델을 연구하다 보면, 인간이 직관적으로 처리하는 언어도 AI에게는 방대한 데이터와 연산이 필요한 복잡한 작업임을 알 수 있습니다.

LLM 모델들의 핵심 기술은 바로 Transformer 모델입니다. Transformer는 자연어 처리(NLP)에서 혁신을 가져온 신경망 구조로, 자연어의 문맥(Context)을 효과적으로 학습하는 "Self-Attention" 메커니즘을 도입했습니다.

- 기존의 RNN(Recurrent Neural Network) 기반 모델은 긴 문장을 처리하는 데 한계가 있었지만,

- Transformer 모델은 멀티 헤드 어텐션(Multi-Head Attention)을 사용해 문장 전체를 한 번에 처리할 수 있도록 개선되었습니다.

LLM은 이 Transformer 모델을 기반으로 대규모 데이터를 학습하며, 이를 통해 문맥을 더 깊이 이해하고 보다 자연스러운 문장을 생성할 수 있습니다.

💡 LLM 모델들의 근간이 되는 Transformer 모델에 대해서는 Transformer, 도대체 그게 뭔데 - Transformer 편에서 이해하기 쉽게 다루고 있으니, 구체적인 동작 방식을 이해하고 싶다면 해당 글을 읽어 보시길 권장드립니다.

4. sLLM의 등장

LLM은 다양한 소통이 필요한 상황에 적합해서, 이를 기반으로 산업 전반에 AI가 활용되는 범위가 넓어졌습니다. 사람이 수행하는 수많은 작업을 자동화할 수 있고, 6시면 종료되는 고객센터 대신 24시간 답변이 가능한 챗봇을 만들수도 있습니다. 인간의 고유 영역이라고 느꼈던 '창작' 영역도 가능해졌습니다.

수 천 억 개의 파라미터가 있는 LLM 모델을 직접 구축하는 것은 어렵지만, 오픈소스로 공개된 기초 모델을 사용하고 싶은 산업/분야에 대한 데이터로 Fine-Tuning 해 사용하는 연구는 계속되고 있습니다. 앞서 언어 모델은 '대화시스템'이 아닌 단어 확률을 학습한다고 언급했지만, 거대한 데이터를 학습시킨 LLM 모델은 하나의 대화형 시뮬레이션으로 성장하고 있습니다. 이러한 모델과 도메인 지식을 잘 활용하면 기업 맞춤형 솔루션을 구축하는 등 다방면으로 활용도가 높아지게 되는데, 덕분에 글로벌 기업뿐만 아니라 우리나라 기업들도 LLM에 대해 적극적으로 투자하고 있는 상황입니다.

하지만 LLM의 수 천 억 개의 파라미터에 대한 부담으로, 최근에는 꼭 파라미터 수가 많아야만 성능이 좋을까에 대한 연구도 진행되고 있습니다. 매개변수가 많을수록 성능이 높아지고 더욱 정교한 기능을 수행할 수 있지만, 때로는 비즈니스 목표에 맞게 최적화 된 경량 모델을 이용하는 것이 더 유리할 수 있습니다. 이러한 배경에서 등장한 게 바로 소형 언어 모델(sLLM) 입니다. sLLM 모델은 파라미터가 수 십 억 혹은 수 백 억대로 비교적 크기가 작은 언어 모델을 말합니다.

이 sLLM이 주목을 받기 시작한 건 올해 초 메타에서 '라마(LLaMA)'가 공개되고 부터인데요, 메타는 라마를 파라미터 수에 따른 4가지 버전을 공개했는데 그 중 가장 작은 모델은 파라미터 수가 70억 개의 불과했습니다. 오히려 작은 파라미터 수를 내세워 다른 모델 용량의 1/10이 된 점과 훨씬 적은 컴퓨팅 파워로도 사용할 수 있는 실용성을 강조했고, 이러한 강점을 살려 오픈소스 형태로 공개 했습니다. 훨씬 적은 파라미터 수를 사용했지만 연구진에 따르면 GPT-3.5와 비교했을 때 질적으로 비슷한 성능을 보이며 sLLM에 대한 기대감을 높였습니다. 경량화를 통해 운영 비용을 줄이고 대신 자신의 산업 분야 등의 데이터로 특화된 모델을 만들고자 하는 접근법이 새로운 트렌드로 떠오르고 있습니다.

현재 진행하고 있는 sLLM 모델인 LlaMA2를 튜닝해 보는 과제의 배경도 공공기관 등의 프로젝트에서 해당 기술을 요구하는 곳이 늘어남에 따라 해당 역량을 미리 갖추기 위해서였습니다.

이렇게 LLM에 대한 기본적인 개념을 알아 보았습니다. 여전히 낯선 단어들도 보이는데요, LLM을 본격적으로 이해하기 위해 다음 포스팅은 Transformer 모델의 인코더-디코더 방식에 대해 정리해 보겠습니다.

< Reference >

1. The Practical Guides for Large Language Models https://github.com/Mooler0410/LLMsPracticalGuide?fbclid=IwAR2jeFAXvKfGh6FGVovC7M5ww2PJgaWpawGAsHf61ISJ8owoBKRcOU5an5M

2. LLM이란 무엇인가? - 정의, 원리, 주요 모델, 적용 사례 https://www.thedatahunt.com/trend-insight/what-is-llm#wae-llm-rarge-ranguage-model-i-jungyohalkka

3. [번역]거대언어모델(LLM) 가이드 https://brunch.co.kr/@brunchgpjz/50

4. LLM (Large Language Model)의 현재와 미래 https://blog.testworks.co.kr/present-and-future-of-large-language-model/

5. 작지만 오히려 좋아! 소형 언어 모델(sLLM) https://www.igloo.co.kr/security-information/%EC%9E%91%EC%A7%80%EB%A7%8C-%EC%98%A4%ED%9E%88%EB%A0%A4-%EC%A2%8B%EC%95%84-%EC%86%8C%ED%98%95-%EC%96%B8%EC%96%B4-%EB%AA%A8%EB%8D%B8sllm/

'Generative AI' 카테고리의 다른 글

| Transformer, 도대체 그게 뭔데 - Transformer 편 (2) (0) | 2025.02.15 |

|---|---|

| Transformer, 도대체 그게 뭔데 - Transformer 편 (1) (1) | 2025.01.19 |

| Transformer, 도대체 그게 뭔데 - Attention편 (33) | 2024.12.07 |

| LLM - Fine Tuning(미세조정) (0) | 2024.03.17 |

| LangChain으로 RAG 구현하기 (0) | 2024.02.04 |